Czy AI sprowadzi na świat Zimę?

Wizja nuklearnej zagłady sprowadzonej na Ziemię przez zaawansowaną technologię oraz następującej po niej nuklearnej zimy pojawiała się już w filmach i popkulturze. Sztuczna inteligencja, która wyrwie się spod kontroli człowieka i zacznie poważnie szkodzić ludzkości to znany nam przekaz, który niestety możemy również czasami obserwować w mediach czy social mediach. Termin „Zima AI” jednak towarzyszy […] Artykuł Czy AI sprowadzi na świat Zimę? pochodzi z serwisu Just Geek IT.

Wizja nuklearnej zagłady sprowadzonej na Ziemię przez zaawansowaną technologię oraz następującej po niej nuklearnej zimy pojawiała się już w filmach i popkulturze. Sztuczna inteligencja, która wyrwie się spod kontroli człowieka i zacznie poważnie szkodzić ludzkości to znany nam przekaz, który niestety możemy również czasami obserwować w mediach czy social mediach. Termin „Zima AI” jednak towarzyszy nam już od lat 70. XX wieku, historycznie opisując rzeczywiste wydarzenia – prawdziwe, choć znacznie mniej przerażające niż sugerują clickbaitowe tytuły.

Zimę AI można określić jako sumę efektów wzlotów i upadków badań nad AI. Pokłosie urzeczenia obiecującą technologią i związanych z nią marzeń oraz konsekwencje niespełnionych oczekiwań. Mroźne okresy objawiały się spadkiem inwestycji w rozwój technologii oraz sceptycyzmem co do możliwości i przyszłości sztucznej inteligencji.

Początkowa fascynacja i pierwsza sieć neuronowa

Badania nad zaawansowanymi algorytmami uczenia maszynowego, ze szczególnym naciskiem na automatyczne tłumaczenie tekstu, rozpoczęły się w pierwszej połowie XX w., a pierwsza sieć neuronowa powstała już w roku 1951!

Po początkowej fascynacji i rozbudzonych oczekiwaniach przyszło rozczarowanie i krytyka zarówno osiągnięć, jak i perspektyw rozwoju. Jeden z pionierów badań – Marvin Minsky – w 1967 r. przewidywał, że w ciągu jednego pokolenia zagadnienie stworzenia sztucznej inteligencji będzie w znaczącym stopniu rozwiązane. Ten sam naukowiec w kolejnych latach wyraził rozczarowanie postępami w rozwoju sieci neuronowych, podkreślając ograniczenia ówczesnego podejścia. W efekcie doszło do wyczerpania nie tylko entuzjazmu, ale też funduszy, a druga połowa lat 70. została zapamiętana jako pierwsza Zima AI.

Ekspert z sieci

Z początkiem lat 80., zainteresowanie próbami rozwoju wczesnych sieci neuronowych przejęły systemy eksperckie. Wykorzystywały one bazy wiedzy zawierające reguły i fakty. Silnik wnioskowania interpretował reguły i stosował je do konkretnych, postawionych przez użytkownika problemów. W swoim założeniu systemy eksperckie miały posiadać wiedzę i dawać rekomendacje na poziomie ludzkiego eksperta. Niestety okazały się drogie oraz nieelastyczne. Nie spełniły oczekiwań i pod koniec lat 80. nastała druga Zima AI.

Skok we współczesność

Od lat 90. obserwujemy odrodzenie badań nad sztuczną inteligencją. Dzięki stałemu wzrostowi mocy obliczeniowej oraz systematycznym odkryciom, przesuwane są granice możliwości tej technologii. Ponownie rozbudzają się oczekiwania.

Śmiało można powiedzieć, że prawdziwą eksplozję zainteresowania AI obserwujemy od momentu udostępnienia ChatGPT przez OpenAI. Zainteresowanie to jest systematycznie podsycane udostępnianiem kolejnych modeli generatywnych: tekstowych, tworzących obrazy, a ostatnio także wideo oraz muzykę (a nawet całe piosenki), a internet codziennie zachęca do kliknięcia i przeczytania o kolejnym przełomie.

Zarówno media, jak i niektóre firmy konsultingowe przewidują, że tym razem technologia doścignie ludzi i być może zastąpi ich w wielu zawodach. Niektórzy nawet postrzegają ją już jako AGI (ang. Artificial General Intelligence), czyli ogólną sztuczną inteligencję równą umysłowi ludzkiemu.

Nowa Zima AI? Uważność potrzebna od zaraz

Czy GenAI jest w stanie spełnić takie oczekiwania, czy też technologia ponownie nas rozczaruje i nastanie kolejna Zima AI?

W celu przybliżenia się do odpowiedzi na to pytanie zbadajmy, czym modele generatywne różnią się od wcześniejszych technik sztucznej inteligencji. Co takiego wyjątkowego kryje się w modelach generatywnych i w słynnym ChatGPT?

Rozwój sztucznej inteligencji od zawsze wiązał się z próbami zrozumienia i przetwarzania języka naturalnego. W tym celu wykorzystywano reguły gramatyczne i podejście lingwistyczne, metody statystyczne oraz sieci neuronowe (np. LSTM). Te ostatnie potrafiły wykorzystać kontekstowe powiązanie między słowami w skali szerszej niż najbliżsi sąsiedzi, jednak nadal uciekał im sens wypowiedzi w dłuższych tekstach.

Prawdziwy przełom to 2017 r. i architektura transformera oraz słynna praca „Attention is All You Need”. Mechanizm uwagi okazał się kluczowy do rozumienia dłuższych wypowiedzi. Bazując na architekturze transformera, zaczęły powstawać coraz większe sieci, trenowane na coraz większych zbiorach danych i… coraz lepiej radzące sobie z zadaniami językowymi. Jednym z pierwszych modeli wykorzystujących architekturę transformerów był model BERT.

W tamtym momencie rozwoju technologii AI tworzenie narzędzi do przetwarzania języka wymagało uczenia modelu lub jego dalszego dostosowywania. Nawet wstępnie wytrenowane modele nie były gotowe na zadania językowe odmienne od tych, do których rozwiązywania je trenowano.

W celu przygotowania modelu sieci neuronowej do nowego problemu konieczne były:

- zebranie danych odwzorowujących dziedzinę problemu,

- specjalistyczna wiedza,

- przeprowadzenie samego uczenia/douczania sieci.

Cofnijmy się do listopada 2022 r. Na scenę wkracza ChatGPT, który nawet w pierwszej wersji, opartej na modelu GPT-3.5, wywołał sensację swoimi możliwościami.

Modele GPT pozwalały na stosowanie ich do wielu zadań zarówno językowych, jak i wymagających wiedzy ogólnej bez konieczności uczenia. Charakteryzują się one bardzo dużą liczbą parametrów, stąd ich nazwa- LLM (Large Language Model – Duże Modele Językowe). GPT-3, poprzednik wersji użytej w ChatGPT, ma 175 miliardów parametrów. Dla porównania, wspomniany wcześniej model BERT w największej wersji to skromne 340 milionów parametrów.

Andrew Ng, były szef Google Brain, następnie działu AI w Baidu, określił te nowe możliwości jako „demokratyzację AI”. Sztuczna inteligencja stała się dostępna dla wszystkich, i to od ręki.

Pułapki wdrożeń AI

LLM-y wraz z rozwojem technologii stają się coraz dokładniejsze, mniejsze i szybsze, ale wciąż mają swoje wady. Najłatwiej zauważyć, że

- halucynują, czyli mogą zmyślać odpowiedzi, mylić się i wprowadzać w błąd,

- nie rozumieją tekstu w sposób, jaki robią to ludzie,

- jakość działania dla specyficznych domen jak medycyna czy specjalistyczne zagadnienia prawne bywa niska,

- ich wykorzystanie w większej skali wiąże się ze znacznymi kosztami.

Obchodzenie tych problemów wymaga wiedzy, doświadczenia i oprogramowania bardziej zaawansowanych schematów interakcji (np. Prompt Chaining czy Chain of Thought), co zwiększa koszty i ogranicza zalety LLM-ów. Sprawia także, że sztuczna inteligencja staje się jakby mniej inteligentna i dostępna.

Aby uniknąć rozczarowań i nadmiernych kosztów, przy wdrażaniu rozwiązań opartych na AI, konieczne jest zbadanie zalet i ograniczeń rozważanych narzędzi oraz ich dopasowanie do konkretnego problemu. Odwrotne podejście bywa frustrujące i nieefektywne. Można wbijać gwoździe mikroskopem, ale istnieją lepsze sposoby.

Przykładowo, w celu wykrywania obiektów na zdjęciach możemy wykorzystać duży model multimodalny lub względnie prostą sieć dedykowaną do takich zastosowań jak sieci YOLO, które są szybsze, tańsze i prawdopodobnie dokładniejsze.

Zadanie odczytania tekstu ze zdjęcia lub zrzutu ekranu także można zrealizować modelem multimodalnym. Jednak proste podejście OCR, wykorzystujące chociażby bibliotekę Tesseract, bazującą na mniejszych sieciach neuronowych, może okazać się bardziej dopasowane do tego problemu. Natomiast, gdy wynik działania klasycznego rozpoznawania znaków będzie zawierał nieakceptowalny stopień błędów, LLM może je skutecznie poprawić.

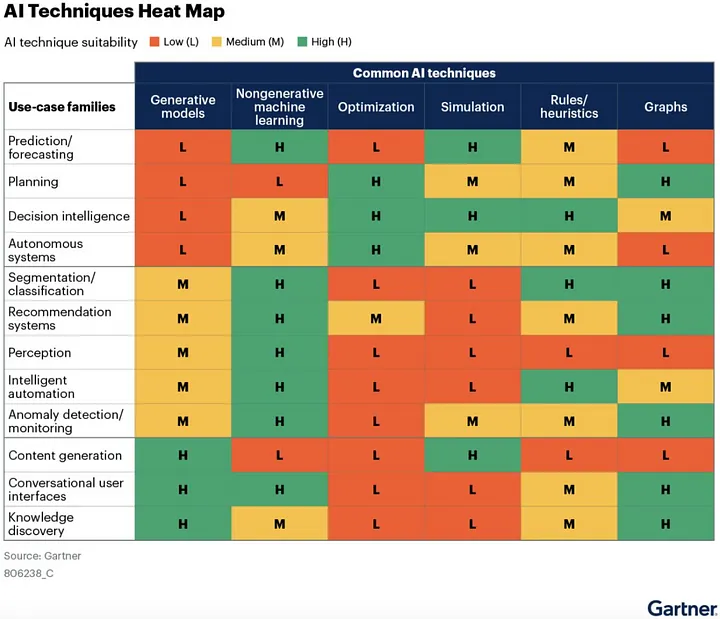

Dopasowanie technologii do rozwiązywanego problemu to ważne zagadnienie. Raport Gartnera z 2024 r. zatytułowany „When Not to Use Generative AI”, w kwestii wykorzystania LLM-ów zawiera następującą wskazówkę:

Tabela przedstawia dopasowanie narzędzia AI do zadania. Kolor zielony oznacza najlepsze narzędzie dla danego zadania. W momencie przygotowania raportu duże modele generatywne nie były najlepszym wyborem dla 9 z 12 rozważanych kategorii problemów.

Postęp technologii mógł już sprawić, że zestawienie straciło swoją aktualność. Uświadamia jednak, że najnowsze, nie zawsze znaczy najlepsze.

We wspomnianym raporcie Gartner zauważa, że często GenAI jest pierwszym doświadczeniem z AI, przez co staje się z nią utożsamiane. Prowadzi to do koncentrowania się na rozwiązaniach opartych wyłącznie na modelach generatywnych i braku świadomości innych technik. Wiele technologii GenAI jest u „szczytu nadmiernych oczekiwań”, co sprzyja przecenianiu ich możliwości oraz niedocenianiu skomplikowania ich wdrażania. Wbrew pozorom, korzystając z ChatGPT, asystenta Gemini czy NotebookLM używamy skomplikowanych rozwiązań, składających się z wielu technik, w tym GenAI. Wszystko to zwiększa prawdopodobieństwo porażek wdrożeń AI i przeszkadza w wykorzystaniu pełnego potencjału sztucznej inteligencji w biznesie.

W PZU przygodę z AI zaczęliśmy zdecydowanie przed nadejściem ery ChatGPT. Jeden z zespołów specjalizujący się we wdrażaniu technologii AI dopasowanych do potrzeb biznesu – Fabryka Sztucznej Inteligencji – powstał w 2018 r. Od tego czasu z sukcesem implementujemy rozwiązania oparte o szerokie spektrum technologii AI. Computer Vision i sieci neuronowe wspomagają m.in. procesy weryfikacji i automatyzacji przepływu dokumentacji ubezpieczeniowej, załączników oraz anonimizacji zdjęć. Techniki NLP, wraz ze słynnymi transformerami, zostały włączone w procesy obsługi korespondencji oraz analitykę likwidacji szkód. Algorytmy przetwarzania szeregów czasowych pozwoliły znacząco poprawić prognozowanie w sprzedaży ubezpieczeń. Jednocześnie nie zamykamy się na nowe. Modele generatywne zawitały w PZU pod postacią Asystenta AI i licznych pilotaży koordynowanych przez zespół GPT Lab. Prace obejmowały m.in. bazy wiedzy (technika RAG) oraz analizę dokumentów.

Rozwaga w doborze narzędzi dyktuje konieczność rozpoznania dostępnych możliwości, weryfikacji założeń, zbadania zarówno dziedziny problemu, jak i dostępnych danych, a także przeprowadzenia wielu eksperymentów.

Z tego powodu projekty AI często mają formułę projektów eksploracyjnych, R&D, o ryzykach ciężkich do oszacowania. W projektach tego typu można mówić o zarządzaniu niepewnością.

Niepewność to nierozłączna cecha uczenia maszynowego i sztucznej inteligencji. Upraszczając, są to narzędzia bazujące na statystyce. Nawet ChatGPT i tzw. prompt engineering (zasady formułowania pytań do modelu) można w dużym stopniu wyjaśnić kierując się intuicją statystyczną. Zaczynając rozmowę od „Jesteś ekspertem od finansów z IQ 150…” zwiększamy prawdopodobieństwo wykorzystania przez model informacji pozyskanych ze specjalistycznej części zbioru uczącego.

Czy czeka nas kolejna Zima AI?

AI nie jest idealne. Popełnia błędy. Ważnym elementem wdrożenia rozwiązania opartego na AI jest spojrzenie na cały proces biznesowy, w którym planujemy tą technologię zastosować. Czy proces ten jest odporny na potencjalne błędy i nieścisłości? Czy przewidziano mechanizmy obsługi ewentualnych błędów?

Odpowiednie dopasowanie narzędzi AI do konkretnego zadania jest kluczowe dla efektywnej realizacji potrzeb biznesu. W obliczu rosnących oczekiwań wobec sztucznej inteligencji i modeli generatywnych, istotne jest, aby działać świadomie i z rozwagą, jednak niech to nie przyćmi ogromnego potencjału, który kryje się w tych technologiach.

Szukajmy skutecznych sposobów na wykorzystanie GenAI – technologii, która dopiero nabiera rozpędu. Znaczna część z nas już korzysta z jej dobrodziejstw i wykorzystuje możliwości LLM-ów w pracy, nauce czy w codziennym życiu. Możliwe, że tym razem nie czeka nas Zima AI, a raczej ciągły jej rozwój – epoka, w której sztuczna inteligencja spełni swoje najśmielsze obietnice.